Tecnología y sociedad

La Inteligencia Artificial puede ser envenenada para proteger los derechos de autor

Se le pueden provocar alucinaciones e impedir que repliquen obras de arte protegidas por copyright

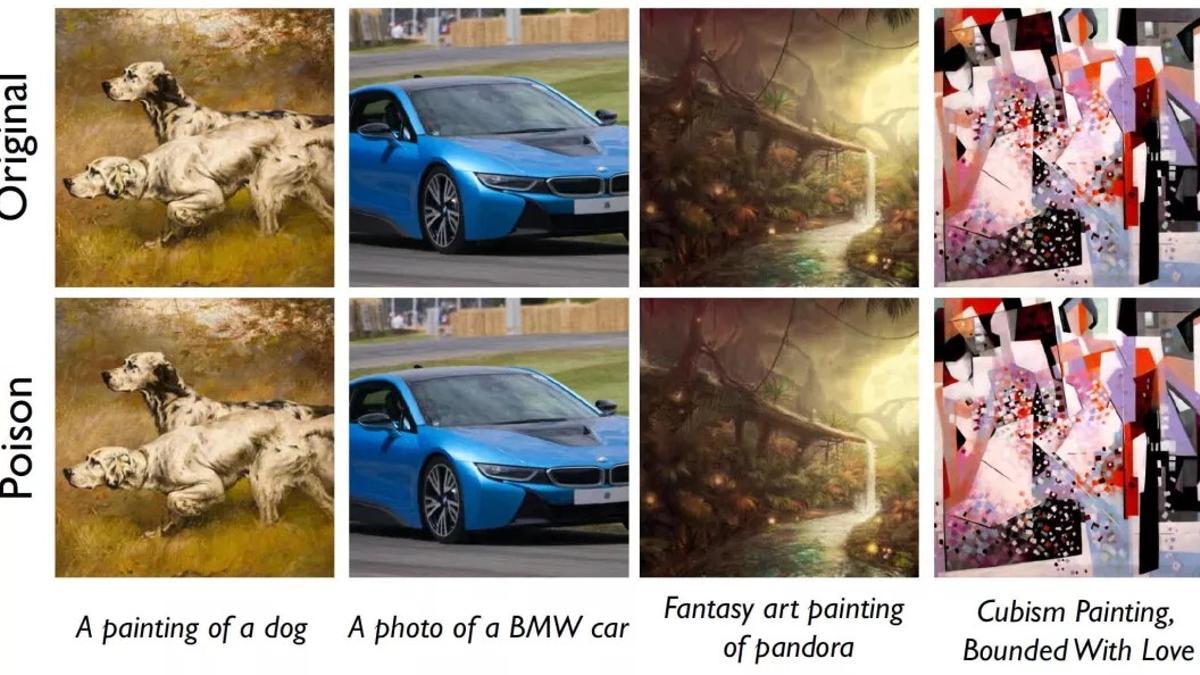

Ejemplos de imágenes originales y envenenadas para confundir a la IA. La diferencia es inapreciable para el ojo humano. / Shawn Shan et al.

Redacción T21

Una herramienta llamada Nightshade cambia imágenes digitales de manera casi imperceptible para el ojo humano, pero que se ven totalmente diferentes por los modelos de IA: una forma polémica de proteger las obras de arte de posibles infracciones de derechos de autor.

En un mundo donde la inteligencia artificial (IA) se ha convertido en una herramienta capaz de generar imágenes con solo unas pocas palabras clave, surge una nueva preocupación: la infracción de derechos de autor.

Los artistas y científicos informáticos han comenzado a luchar contra esta tendencia utilizando una técnica conocida como "envenenamiento de datos" para proteger sus obras de ser replicadas sin permiso.

Creando alucionaciones

Nightshade es una herramienta desarrollada por investigadores de la Universidad de Chicago que modifica sutilmente las imágenes de manera que son casi imperceptibles para el ojo humano, pero que resultan en visiones drásticamente diferentes para las plataformas de IA que las procesan.

Este método de "envenenamiento" hace que los modelos de IA "alucinen" gatos, por ejemplo, cuando en realidad están viendo perros. Esta técnica se basa en la diferencia fundamental entre cómo los humanos y las máquinas "ven" las imágenes.

Mientras que los humanos interpretan una imagen en su conjunto, las IA la procesan como un arreglo de números, con valores de píxeles que varían de cero a 255.

Síntomas de la intoxicación de datos

Nightshade altera miles de píxeles, una cantidad pequeña en comparación con imágenes que contienen millones de píxeles, pero suficiente para engañar a una IA y hacer que vea "algo que es completamente diferente", explica Shawn Shan de la UoC, en un artículo publicado en arXiv.

Los síntomas de la intoxicación de datos pueden ser variados y sorprendentes. Por ejemplo, una IA entrenada con imágenes "envenenadas" podría confundir un globo con un huevo o una sandía.

Los modelos de IA también podrían reintroducir errores previamente superados, como problemas en la representación de manos, o crear características ilógicas, como perros con seis patas o sofás deformes. Cuantas más imágenes "envenenadas" contenga el conjunto de datos de entrenamiento, mayor será la perturbación.

Impacto en la IA Generativa

El daño causado por las imágenes "envenenadas" no se limita a la imagen en cuestión; afecta también a términos de búsqueda relacionados, advierten los autores de este trabajo.

Por ejemplo, si una imagen "envenenada" de un Ferrari se utiliza en los datos de entrenamiento, los resultados de la IA para otras marcas de automóviles y términos relacionados como "vehículo" o "automóvil" también pueden verse afectados.

El envenenamiento de datos plantea un dilema ético y legal en la intersección de la tecnología y los derechos de autor.

Lado oscuro

Mientras que herramientas como Nightshade buscan empoderar a los artistas y hacer que las grandes empresas tecnológicas respeten más los derechos de autor, también existe el riesgo de que los usuarios abusen de estas herramientas para interrumpir intencionalmente los servicios de IA.

La búsqueda de soluciones tecnológicas y humanas es crucial para garantizar que la creatividad y la propiedad intelectual coexistan armoniosamente con la innovación tecnológica.

Al respecto, los creadores de Nightshade consideran que esta tecnología es un primer paso en esa dirección y animan a los entrenadores de modelos y propietarios de contenido a negociar un camino hacia la adquisición con licencia de datos capacitando adecuadamente los futuros modelos de IA.

Al mismo tiempo, advierten que su tecnología pone manifiesto las limitaciones fundamentales de los modelos de IA Generativa y advierten que están expuestos a ataques aún más poderosos.

Referencia

Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models. Shawn Shan et al. arXiv:2310.13828v2 [cs.CR] 16 Feb 2024.

- Máxima alerta de la Policía Nacional a la población por lo que está pasando con el DNI

- Máxima alerta de la Policía Nacional por las monedas de dos euros falsas: así se identifican

- Juanma Moreno: "De nada sirve un estadio con 45.000 espectadores si no lo acompaña el equipo

- Así serán las nuevas universidades privadas de Málaga

- Una borrasca barre la costa y deja lluvia en La Viñuela

- Sigue en directo el Córdoba CF - Málaga CF

- Denunciados casi cien vehículos VTC en el aeropuerto de Málaga por incumplir la normativa

- Un siglo de la Casa de las Palmeras de Guerrero Strachan